Data + SEO

Ce matin, j’ai entamé la création de mon profil Malt.

Je me suis donc installé à mon bureau et ai commencé à réfléchir à propos de mon positionnement. L’objectif est de se démarquer parmi tous les profils concurrents. Mais comment faire ?

Depuis plusieurs semaines maintenant, je réfléchis à une manière d’incorporer mes compétences en data à mes projets SEO. Ça ne pourra que m’être bénéfique. Je pourrais me replonger dans cet univers et développer mes compétences aux yeux de mes futurs clients mais aussi de mes potentiels futurs employeurs (bien que je ne souhaite pas particulièrement me faire ré-embaucher)

Ma question

Aujourd’hui, j’ai donc demandé à mon meilleur ami, ChatGPT, la question suivante :

“Mets toi dans la peau d’un data analyst. Que ferait-il pour exploiter un maximum les données SEO d’un site et apporter des résultats extraordinaires ?”

Sa réponse

Sa réponse m’a inspirée. Elle m’a donné envie de faire mieux, d’exceller :

Voici, en tant que data analyst, une feuille de route concrète et priorisée pour exploiter au maximum les données SEO d’un site et obtenir des résultats mesurables et rapides.

1. Objectif principal

Mesurer, piloter et optimiser le trafic organique et la conversion en s’appuyant sur données fiables, tests systématiques et automatisation.

2. Sources de données à agréger (ordre de priorité)

- Google Analytics / GA4 (visites, conversion, pages, chemins).

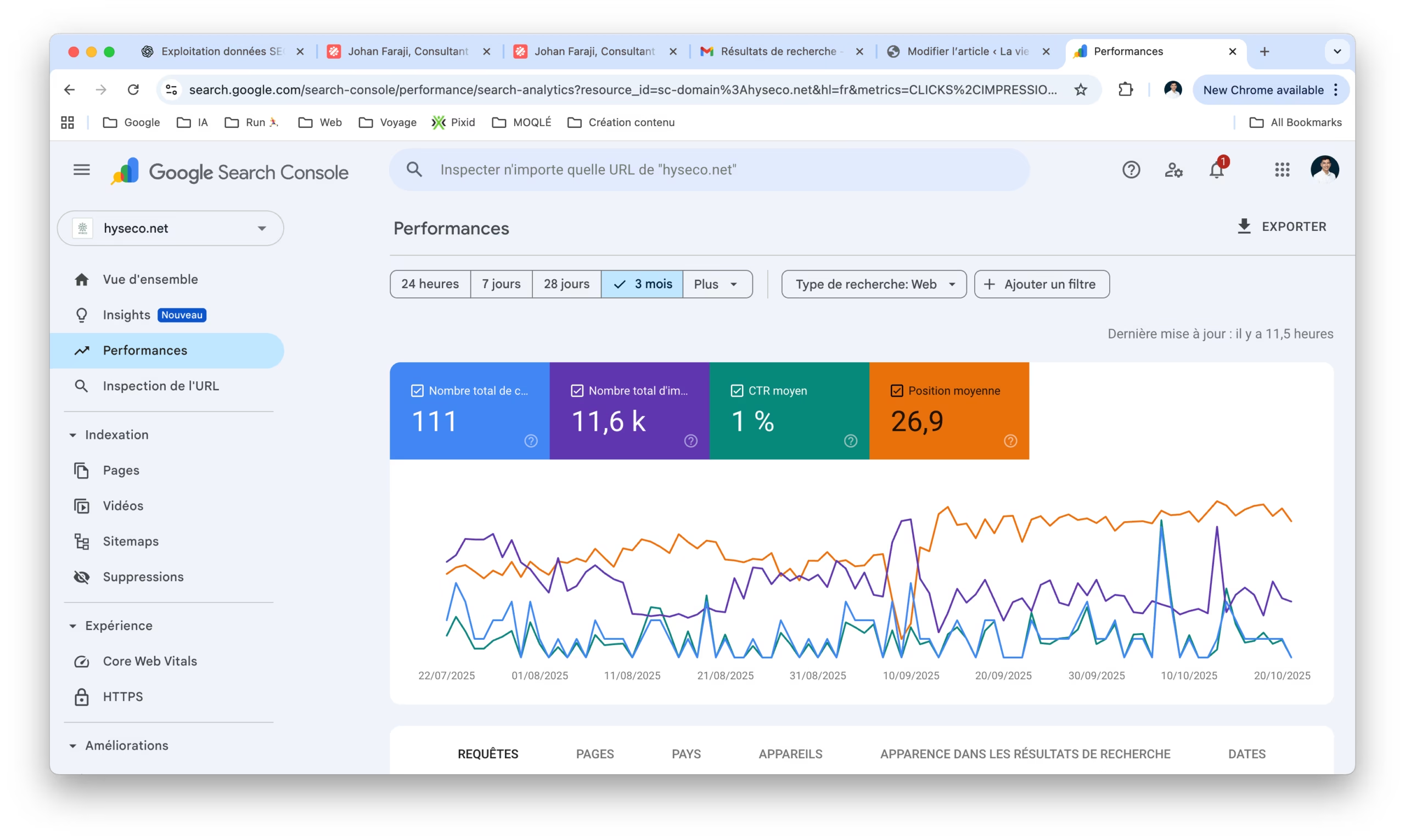

- Google Search Console (impressions, CTR, positions, requêtes).

- Logs serveur (crawl bots, erreurs, temps de réponse).

- Crawls SEO (Screaming Frog / Sitebulb) — structure, balises, erreurs 4xx/5xx, canonicals.

- Données de mots-clés / volume & concurrence (Ahrefs / SEMrush / Keywords API).

- Backlinks (profil, qualité, anchor).

- Données de performance (Lighthouse / Core Web Vitals).

- CRM / conversion offline (si disponible) pour attribution.

- Données concurrentielles publiques (SERP features, positions).

3. Infrastructure & pipeline (rapide)

- Centraliser en un entrepôt (BigQuery / Snowflake / Postgres).

- ETL régulier : GSC + GA4 + crawl + logs + backlinks → tables normalisées.

- Versionner les transformations (dbt) et stocker snapshots temporels (séries historiques par jour).

- Dashboarding (Looker / Data Studio / Metabase) + alerting (Slack/Email).

4. KPIs clés (mesurables)

- Trafic organique sessions / utilisateurs (journalier/hebdo/mois).

- Impressions, CTR moyen, position moyenne par groupe de pages.

- Taux de conversion organique (micro + macro).

- Valeur/ROI par page/topic (revenu attribué).

- Core Web Vitals (LCP, FID/INP, CLS) par template.

- Nombre et qualité des backlinks nouveaux par mois.

- Temps de crawl & budget crawl utilisé.

5. Analyses prioritaires (actions immédiates)

- Audit de santé (crawl + logs + GSC anomalies) → corriger 5xx, redirections, canonicals, noindex accidentel.

- Segmentation des pages par template et intent (commerciale / informationnelle / navigationnelle).

- Analyse gap keywords : pages proches du top 10 à fort volume → prioriser pour optimisation on-page + internal linking.

- CTR optimisation : titres & meta descriptions pour pages avec impressions élevées mais CTR bas.

- Performance technique : corriger templates avec mauvais Core Web Vitals qui génèrent le plus de trafic.

- Backlink quick wins : identifier contenus linkables et lancer outreach ciblé.

6. Analyses avancées (appliquer ensuite)

- Modèle d’attribution multi-touch simple pour mesurer contribution SEO aux conversions.

- Analyse de causalité (difference-in-difference) pour valider impact d’une refonte ou d’un test de contenu.

- Clustering sémantique des pages + génération automatique de silos / pages pilier.

- Forecasting de trafic par cluster via séries temporelles (ARIMA / Prophet) pour prioriser effort.

- Détection d’anomalies (statistical + ML) sur CTR / position / trafic pour alerter automatiquement.

- Analyse des logs pour optimiser crawl budget (bloquer pages non nécessaires, améliorer profondeur important).

- A/B testing SEO pour expériences de titres / snippet (via changement contrôlé + suivi positions/CTR).

7. Automatisations à mettre en place (gains de productivité)

- Job quotidien : importer GSC + GA4 → calculer positions, CTR, pages en baisse → créer ticket sous JIRA/Notion.

- Génération automatique de briefs SEO pour rédacteurs (mots-clés cibles, intent, concurrents, points à couvrir).

- Script d’audit on-page (check Hn, meta, longueur contenu, density) et checklist corrective.

- Monitoring continu Core Web Vitals + alertes.

- Envoi hebdomadaire d’un rapport client synthétique (KPIs, anomalies, tâches).

8. Tests & expérimentation (méthodologie)

- Hypothèse claire (ex : « optimiser H1 + meta augmente CTR de 20% en 4 semaines »).

- Définir groupes test / contrôle (pages similaires en trafic et intent).

- Déployer changement sur test, monitorer GSC/GA4 4–8 semaines, mesurer delta positions/CTR/conversion.

- Valider statistiquement (p-valeur / taille d’effet) avant déploiement global.

9. Priorisation tactique (RICE adapté SEO)

- R = Reach (visites impactables), I = Impact (gain potentiel), C = Confidence (données soutenant), E = Effort (heures/dev).

- Calculer score = (R×I×C)/E → exécuter top actions à court terme.

10. Livrables & cadence opérationnelle

- Dashboards temps réel + vues journalières pour anomalies.

- Rapport hebdo synthétique (3 slides) : évolutions, 3 actions réalisées, 3 priorités suivantes.

- Rapport mensuel détaillé : tests, ROI, roadmap.

- Playbook d’optimisation réutilisable (templates, scripts, checklists).

11. Exemples pratiques rapides (snippets)

- Exemple SQL minimal (pages proches du top10) :

SELECT page, avg(position) AS pos, sum(impressions) AS impressions

FROM gsc_table

WHERE date BETWEEN DATE_SUB(CURRENT_DATE, INTERVAL 28 DAY) AND CURRENT_DATE

GROUP BY page

HAVING pos BETWEEN 6 AND 12

ORDER BY impressions DESC

LIMIT 200;

- Déclencher ticket pour chaque page avec impressions>1000 & CTR<median(CTR) : automatisable.

12. Organisation et compétences requises

- Data engineer (pipeline), Data analyst/SEO analyst, dev front/tech SEO, rédacteur SEO.

- Outils : BigQuery/Postgres, dbt, GA4 API, GSC API, Screaming Frog, un outil backlinks, Metabase/Looker.

13. KPI de succès à 3–6 mois

- +20–50% de pages en top10 sur les cibles prioritaires.

- Augmentation CTR moyen de 10–30% sur pages optimisées.

- Croissance durable du trafic organique qualifié + augmentation du taux de conversion organique.

- Temps de résolution des anomalies SEO < 48h via alerting.

14. Risques & garde-fous

- Ne pas implémenter massivement sans tests (risque de régression).

- Garder backups et rollback pour modifications globales (templates, canonicals).

- Vérifier que les optimisations respectent les guidelines Google (éviter sur-optimisation).

Résumé en une phrase : centraliser les données, automatiser la détection d’opportunités et d’anomalies, tester scientifiquement chaque optimisation, et prioriser selon ROI mesurable.

Sommaire